X

Marco Mezquida "Piano + AI"

Marco Mezquida es un pianista virtuoso al cual no se le resiste ningún repertorio, se siente en casa tanto con la música clásica como en el jazz y es un excelente improvisador.

A lo largo de su carrera ha tocado con instrumentistas de todos los géneros, y esta vez, su colaboradora en el escenario será una inteligencia artificial.

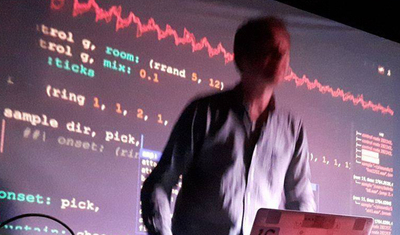

Marco Mezquida “Piano + AI” es un proyecto de co creación junto a científicos e ingenieros de la Universidad Politécnica de Catalunya (UPC) quienes han desarrollado un instrumento de inteligencia artificial que reconoce las diferentes técnicas del pianista y responde en tiempo real con diferentes paisajes sonoros de síntesis, generando un feedback entre el pianista y la inteligencia artificial.

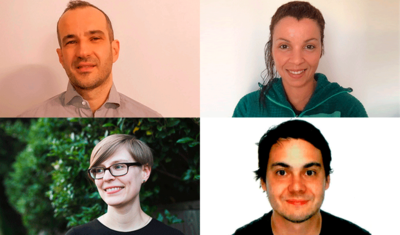

Han trabajado en el proyecto Iván Paz, músico e investigador especializado en el uso de la inteligencia artificial dentro de la práctica del livecoding; Philippe Salembier ingeniero especializado en procesamiento digital de señales y de imagen.

En el diseño sonoro han colaborado Josep Maria Comajuncosas, músico, ingeniero informático y profesor del ESMUC (Escuela Superior de Música de Catalunya), y Joan Canyelles (Shelly) músico e ingeniero en sistemas audiovisuales.

Los ensayos del concierto se han llevado a cabo en ESMUC y también se ha contado con la colaboración de la pianista Anna Francesch.

Demo Research 1:wAIggledance

wAIggledance

La IA creativa se centra sobretot en l'ús del machine learning i del deep learning i és refrescant descobrir projectes que usen eines i conceptes dels sistemes complexos i de la “swarm intelligence”, un comportament col·lectiu dels sistemes autoorganitzats, ja siguin naturals (un eixam d'abelles, d'aquí el nom) com a artificials.

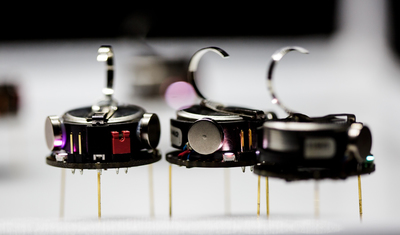

wAIggledance investiga les implicacions estètiques i filosòfiques de la col·lectivitat i l'autoorganització d'agents a partir d'un "eixam" de Kilobots, uns petits robots que poden executar algorismes senzills, es mouen per vibració de motors i són capaços d’intercanviar missatges amb els seus veïns en un radi d'aproximadament 10 centímetres.

En moure's generen sons que depenent del nivell de sincronització en el seu moviment fa que emergeixin patrons rítmics.

Les autores del projecte Lina Bautista (artista) i Júlia Múgica (artista i científica) han treballat tant en la creació i catalogació d'algorismes com en la construcció dels prototips electrònics.

LP Duo presents: Beyond Quantum Music

Desde 2004, el dúo serbio de piano clásico formado por Sonja Loncar y Andrija Pavlovic ha experimentado con las posibilidades infinitas de interpretar con dos pianos, sus explosivas interpretaciones de trabajos clásicos les han situado en algún lugar entre una orquesta de cámara y una banda de rock.

En el AI & Music S+T+ARTS festival, el dúo presentará una performance en vídeo que captura su habitual interés en la física cuántica y el audio generativo. Titulada “Beyond Quantum Music”, la pieza hace referencia a su epónima investigación de arte y ciencia junto a la Universidad de Oxford, Ars Electronica en Linz, el festival TodaysArt, el Instituto de Musicología SASA en Belgrado, y las universidades de Aarhus y Hannover; diluyendo las líneas entre composición, interpretación y performance.

en colaboración con Quantum Music

Demo Research 2: Polifonia

Polifonia: Interpretar la banda sonora de nuestra historia.

Desde el paisaje sonoro de las históricas campanas italianas, a la influencia de las óperas francesas en la música tradicional alemana, la herencia cultural europea esconde una auténtica mina de oro de encuentros desconocidos, influencias y prácticas que pueden trasladarnos a un viaje en el tiempo, entender mejor la música que nos gusta e imaginar la banda sonora del futuro. Este es el objetivo de Polifonia, una iniciativa de la Universidad de Bologna que quiere provocar un cambio de paradigma en las políticas de preservación del legado musical, metodologías de investigación y medios y estrategias de promoción.

Para ello, se utilizan enfoques tecnológicos que faciliten el acceso al legado musical europeo para permitir una reutilización creativa de la herencia musical a gran escala, conectando tanto el patrimonio tangible (instrumentos, teatros....) como intangible, y cruzando por primera vez datos hasta ahora desconectados.

Presentará el proyecto la profesora de la Universidad de Bolonia y responsable del proyecto Valentina Presutti.

Human Brother

El proyecto conjunto del reconocido compositor Ferran Cruixent y Artur Garcia, un investigador clave en el Barcelona Supercomputing Center, Human Brother es una obra para soprano y orquesta que explora la relación entre los humanos y la inteligencia artificial.

Una colaboración entre una de las voces más destacadas en la música clásica contemporánea y un miembro del equipo que construyó el primer ordenador cuántico del BSC, esta colisión entre dos mundos aparentemente separados es, en sí misma, una metáfora de las posibilidades creativas de las probabilidades aleatorias de crear arte a partir de la ciencia.

en colaboración con Barcelona Supercomputing Center

YACHT

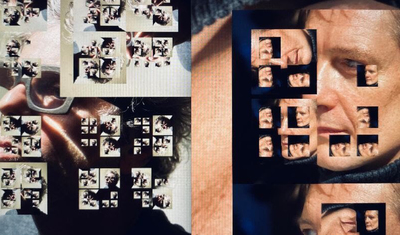

Para componer su álbum nominado a un GRAMMY Chain Tripping, el dúo de post-pop YACHT creó una técnica de collage algorítmico “friqui y hecha a medida”, tomando de una variedad de modelos de machine learning para generar los patrones melódicos y rítmicos que usan como material fuente para su proceso composicional de “corta y pega”.

Para ello, trabajaron con reglas autoimpuestas: todo debía ser generado a partir de su propio catálogo y sin espacio para la improvisación. Estas constricciones obligaron a la banda a buscar subversiones y atajos creativos dentro de las limitaciones de la propia tecnología. Para el AI & Music Festival, YACHT romperán sus propias reglas –tomando lo mejor que ofrece el machine learning como herramienta creativa al tiempo que dejan espacio para lo inesperado, lo inexplicable y lo humano.

Bot Bop - Integers & Strings

BotBop se formó en 2019 a petición especial del centro de arte BOZAR en Bruselas para investigar nuevas direcciones artísticas en la música, utilizando tecnología puntera del campo de la inteligencia artificial.

El instrumentista de viento y aficionado del sintetizador modular Andrew Claes y el geek del live coding Dago Sondervan fueron reclutados para preparar una performance especial en coproducción con Ars Electronica. El ingeniero e investigador Kasper Jordaens se sumó al equipo aportando su expertise en machine learning, y así fue como nació BotBop.

En esta segunda iteración de la saga BotBop, Dago Sondervan, Andrew Claes y Kasper Jordaens se unen otra vez para un nuevo reto: incorporar un cuarteto clásico de cuerda como vehículo para explorar nuevas posibilidades en una impactante actuación audiovisual generada en tiempo real.

Este viaje exploratorio en el potencial artístico de la IA incorporará un entorno interactivo que desborda la improvisación y la composición asistida por ordenador.

BotBop usarán primordialmente software open source y herramientas hechas a medida del proyecto, para permitir la generación de partituras en tiempo real y repartirlas en partes individuales para un cuarteto de cuerda.

Una partitura generada en tiempo real guiará al cuarteto de cuerda y será manipulada visualmente por Jordaens y proyectada en una pantalla, resaltando el contenido generado y añadiendo una capa gráfica inmersiva.

La performance consta de cinco movimientos separados y cada uno de ellos refleja una idea específica. Para generar los ritmos se utilizaran diversas estrategias, como divisiones euclídeas, secuencias de fibonacci y otras estructuras matemáticas; mientras que el contenido melódico estará moderado por la IA.

En el escenario actuarán los interpretes: Andrew Claes, Dagobert Sondervan, Kasper Jordaens, Pieter Jansen, Herlinde Verjans, Jasmien Van Hauthem, Romek Maniewski-Kelner.

una coproducción de Sónar y Bozar

DIANA AI Song Contest

A collaboration between Sónar and ℅ Pop Festival in Cologne, DIANA Song Contest is the brainchild of Jovanka v. Wilsdorf, a Berlin-based musician, artist producler, and songwriter at BMG Rights Management. The audiovisual piece follows the competition and performances of the second annual DIANA Song Contest, a collaborative AI and songwriting camp where the music is created live and on location. The project’s mission is to actively promote the bcreative dialogue between musicians and AI software, and to kick off inspired collaborations as well as strong songs going beyond genre bubbles.

presentado por c/o festival

Hexorcismos

Los campos electromagnéticos y la electricidad son la fuerza vital del reino digital y de la inteligencia artificial. En esta exclusiva performance para el AI & Music Festival, Hexorcismos, el aka artístico del artista digital berlinés Moisés Horta, toma un enfoque multi sensorial para un ritual animista protagonizado por la IA, sonidos y visuales sintetizados, y los efectos escalofriantes de los micrófonos electromagnéticos; explorando las cualidades sonoras no-humanas de los dispositivos digitales.

Filmado en directo en el estudio XR de Factory Berlin, estas energías se canalizan a través de un ritual tecnochamánico y desembocan en un intenso paisaje sonoro asistido por una red neuronal personalizada llamada Djembe AI.

en colaboración con Factory Berlin

Chameleon’s Blendings performed by a OBC’s String Quartet and pianist Fani Karagianni

Para esta pieza audiovisual exclusiva, presentada por la plataforma de investigación y comunicación sobre inteligencia artificial Artificia, nos introducimos en las entrañas de AI Chameleon, una GAN de la Universidad de Tesalónica, capaz de generar armonías musicales que pueden ser interpretadas por varios músicos. En esta cápsula de 15 minutos, un cuarteto de cámara con músicos de la OBC de Barcelona y la pianista griega Fanny Karagianni interpretarán versiones de estas armonías en una interacción entre creación humana y composición algorítmica.

en colaboración con Artificia

Interpreting Quantum Randomness: Concept by Reiko Yamada and Maciej Lewenstein

Si la música es matemáticas, es lógico que aplicando teorías matemáticas avanzadas a la propia estructura de la música, aparezcan sonidos hasta ahora inéditos. Este es el amplio marco conceptual que yace en el trabajo de la compositora y artista sonora japonesa Reiko Yamada, cuyo trabajo “Of Randomness and Imperfection”, busca extraer sonidos únicos de la verdadera y genuina aleatoriedad cuántica de los sistemas físicos.

Desarrollado junto al Profesor Dr. Maciej Lewenstein (ICFO, Barcelona) el show resultante “Interpreting Quantum Randomness”, presenta los resultados de esta investigación: una serie de timbres y frecuencias radicalmente nuevos, creados a partir de la aplicación de los principios de la teoría cuántica a la música, una aproximación estética al nivel de la aleatoriedad cuántica que existe en la naturaleza.

en colaboración con ICFO

Hongshuo Fan ‘Metamorphosis’

Seleccionado a partir de una convocatoria abierta de proyectos en la intersección de la inteligencia artificial y la performance musical, Metamorphosis de Hongshuo Fan es una composición audiovisual interactiva en tiempo real para un intérprete humano y dos intérpretes intelectuales artificiales, basada en improvisaciones sobre el Bianqing (磬) un antiguo instrumento de percusión chino. A lo largo de la actuación, el sonido y la forma del instrumento evolucionan constantemente, en relación a la interacción y la interpretación de los performers tanto humanos como artificiales. De lo antiguo a lo moderno, de lo concreto a lo abstracto, la fusión del sonido, imagen y actuación en directo crean una experiencia inmersiva que explora el cambio y la coevolución entre humanos e IA.

Franz Rosati ‘Latentscape’

El músico, artista digital y profesor Franz Rosati presenta su último proyecto “Latentscape” en el AI and Music Festival.

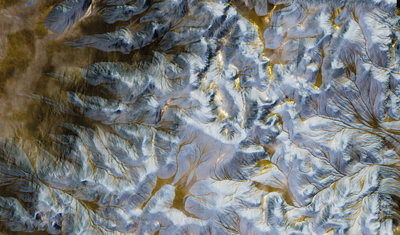

El trabajo, explícitamente diseñado como una serie de conciertos AV, representa la exploración de territorios y paisajes virtuales, generados con algoritmos de machine learning entrenados con música pop y folk exenta de limitaciones culturales y temporales.

Empleando GANs entrenados con datasets de imágenes satelitales de acceso público (y deliberadamente manipuladas para favorecer la aleatoriedad), el trabajo quiere descontextualizar y cuestionar la noción de fronteras y límites geográficos y culturales, resultando en un trabajo donde los flujos de pixeles toman forma de grietas, erosiones o montañas, y donde los colores y texturas son la representación virtual de recuerdos y emociones que el territorio expresa a través de su forma.

Demo Research 3: ‘Jazz as Social Machine’

No hay ningún género musical que escape a la experimentación con la inteligencia artificial. De todas las músicas posibles, el jazz es la más esquiva: la energía de los instrumentos de viento es un reto para las redes neuronales, el virtuosismo del que hacen gala los intérpretes de jazz tampoco es cosa fácil para los algoritmos, sin descontar la naturaleza social e improvisatoria del jazz: las inteligencias artificiales todavía no pueden interpretar los gestos, miradas y otras interacciones con los que los músicos de jazz se ponen de acuerdo para tocar.

Dentro de este contexto se encuentra un proyecto de investigación llamado "Jazz As Social Machine", una iniciativa del Alan Turing Institute liderada por el Dr. Thomas Irvine, donde investigan las interacciones sociales que tienen lugar dentro de la improvisación, así como la memoria histórica del jazz, que cada intérprete lleva consigo y que todavía no es transferible a la red neuronal más compleja.

Nabihah Iqbal and Libby Heaney

"The Whole Earth Chanting" es una grabación y performance en vivo de la artista y física cuántica Libby Heaney y la música y etnomusicòloga Nabihah Iqbal. El trabajo emplea el poder de la voz, el sonido y la música, y la intimidad de la performance para explorar nuevas expresiones de pertenencia e identidad colectiva entre humanos y no-humanos; una espiritualidad posthumana, que entrelaza la percepción humana con el mundo material.

Una colaboración en directo entre una IA generativa entrenada con ejemplos de cantos, tanto humanos como no humanos, y los sintetizadores y voces de Nabihah Iqbal, la pieza empuja contra los usos más extendidos de la inteligencia artificial para gestionar (supuestos) riesgos al servicio del status quo. Mientras los cantos religiosos se funden con los himnos de los fans del fútbol, los cantos de los pájaros y la voz de Iqbal, las barreras de las categorías que usamos para entender el mundo se disuelven, creando un viaje trascendental que permite “al otro" a entrar y transformar.

Este trabajo es un encargo original de Radar Loughborough como parte de su programa Risk Related.

AWWZ b2b AI DJ

Una de las tres cocreaciones especialmente creadas por el Festival, AWWZ b2b AI Dj es una colaboración única entre la productora y dj Awwz, y un equipo de investigadores de la UPC: Mireia de Gracia, Casimiro Pio y Marta Ruiz Costa-Jussà.

En este show se entrecruzan la clasificación de géneros con inteligencia artificial, la performance y la participación del público. Una IA especialmente entrenada traducirá los comentarios de youtube en sugerencias de canciones. La selección de canciones resultante será elegida por el DJ en un proceso de colaboración, que invita a reflexionar sobre cuestiones de gusto musical y la capacidad de un dj para "leer" al público, además de señalar el camino hacia el futuro del dj.

cocreado por Sónar y la UPC

Holly Herndon presents Holly+ featuring Maria Arnal, Tarta Relena and Matthew Dryhurst

Si la artista, compositora e investigadora Holly Herndon es ya en sí un avatar conceptual de lo que es posible en el diseño de sonido algorítmico y asistido por IA, con la aparición de su último proyecto Holly+ se ha convertido en una realidad (virtual).

Una herramienta basada en inteligencia artificial para procesar sonido polifónico, apoyado en una DAO (Organización Autónoma Descentralizada en el blockchain), Holly+ es un retrato de audio digital de la artista que “canta” el audio subido al sistema con la voz de la artista. Para esta presentación especial en el AI and Music Festival, Holly realizará una residencia en Barcelona, en Hangar con tres de las artistas vocales más innovadoras de la ciudad –Maria Arnal y el dúo Tarta Relena– unos días antes de presentar los resultados en un show en directo de Holly+ acompañada de su partner creativo Mat Dryhurst.

Una demostración imperdible del potencial creativo de la AI, y del poder de la voz humana.

Rob Clouth A/V Live

Trabajando en la vanguardia de la música generativa, la imagen y el diseño de sonido, Rob Clouth es un artista y desarrollador con base en Barcelona cuyo trabajo repiensa como interactuamos con la música y la tecnología. En el AI & Music Festival, Clouth presentará su nuevo proyecto audiovisual Zero Point, un trabajo que explora temas de casualidad, caos, coincidencia y lo efímero, utilizando la energía del punto cero de la mecánica cuántica como concepto unificador.

Usando un sistema generativo 3D que el mismo artista a desarrollado, Clouth ha creado un lenguaje único de destellos y espacios mutantes con una percepción que cambia de forma fluida desde la escala subatómica a la planetaria, una reflexión sobre la ubicuidad de la energía del punto cero extendiéndose a cada rincón del universo.

Hamill Industries & Kiani del Valle ‘ENGENDERED OTHERNESS. A symbiotic AI dance ensemble’

Una espectacular cocreación entre los artistas visuales Hamill Industries, la premiada coreógrafa Kiani del Valle y un equipo de especialistas de la UPC, “Engendered Otherness - A symbiotic AI dance ensemble”, une el audio generativo, la visión por computador y la danza en un show audiovisual que empuja los límites del cuerpo humano hacia nuevos territorios gracias a las posibilidades de la IA.

Este trabajo representa otro punto álgido para Hamill Industries, el prestigioso estudio de diseño visual barcelonés regentado por Pablo Barquín y Anna Díaz. Inspirándose en la biología y en las teorías de evolución de las especies, Hamill creará un ensemble de danza de seres artificiales que mutan, evolucionan y reaccionan a la pauta coreográfica de Kiani. Estas criaturas han aprendido de los movimientos de la bailarina mediante técnicas de visión por computador, captura de movimiento y algoritmos de inteligencia artificial.

Hamill Industries son reconocidos por su continuado trabajo al lado de Floating Points; en esta ocasión se unen a la coreografa y bailarina puertorriqueña Kiani del Valle, fundadora de KDV Dance Ensemble, compañía con la cual ha trabajado con músicos como Matthew Dear, Dirty Projectors, Kasper Bjørke, Unknown Mortal Orchestra y Clark, entre otros.

En la parte científica ha trabajado un equipo de especialistas en IA de la UPC, formado por Stefano Rosso, graduado en energía y sostenibilidat, científico de datos y colaborador de la artista Sofía Crespo; Martí de Castro, ingeniero industrial especializado en visión por computador y doctorando en inteligencia artificial; y Javier Ruiz Hidalgo, investigador y doctorado en procesamiento de la imagen.

cocreado por Sónar y la UPC

Mouse On Mars ‘AAI Live’

El pionero dúo alemán formado por Jan St.Werner y Andi Toma ha estado a la cabeza de la música electrónica experimental durante más de 25 años. Su último proyecto toma este legado rico en experimentación para ofrecer una lectura radical del momento creativo presente, explorando la inteligencia artificial tanto como marco narrativo como herramienta compositiva.

Creado en colaboración con el escritor y académico Louis Chude-Sokei y el grupo de “arquitectos IA” Birds on Mars, el núcleo del proyecto es un software a medida, capaz de modelar el habla, el cual, manipulado como un instrumento por St.Werner y Toma, añade una capa extra de creatividad ( y de ambigüedad conceptual), al proceso. El resultado es un trabajo que cuestiona la naturaleza de la autoría y la originalidad, al tiempo que muestra el increíble potencial de las herramientas IA en la composición electrónica.

SYNC by Albert van Abbe

El primer secuenciador de hardware IA ha sido concebido por el músico Albert van Abbe, desarrollado por el profesor de la universidad de Eindhoven Mathias Funk, y prototipado por la compañía BMD, entre otros socios.

Para el artista sonoro Albert van Abbe, SYNC es el perfecto proyecto de pandemia. Una máquina hiper personal que genera nuevas notas midi a partir de música que el ha realizado en los últimos 20 años. SYNC dispara sintetizadores y cajas de ritmos además de luces led e incluso vídeo en tiempo real y de manera simultánea.

Albert van Abbe, quien se autoproclama como un veterano “constructor de sonido”, durante sus 20 años de carrera ha cubierto todo el espectro de la música electrónica: de instalaciones sonoras minimalistas a producciones acid inflexibles, pasando por una larga lista de trabajos colaborativos; desde alianzas institucionales a proyectos con artistas de diferentes medios para añadir a una lista excitante de actuaciones dentro y fuera del club.

Realizador: Mark Richter

Grabado en Grey Space (La Haya)

Presentado en colaboración con TodaysArt

DanzArte - Emotional Wellbeing Technology

DanzArte nos enseña a ver una obra de arte gracias a la comunicación no verbal, el sonido y gestos de baile. Se trata de un proyecto de innovación tecnológica de cultura y salud, un sistema interactivo de inteligencia artificial, de tecnología y de bienestar emocional.

Pequeños grupos son invitados a emular el movimiento afectivo evocado en una pintura, mientras que un sistema de inteligencia artificial mide en tiempo real las señales emocionales del movimiento corporal, con el fin de usarlas en una manipulación visual de la pintura y para sonificar la emoción contenida en el movimiento.

El proyecto está diseñado para el tratamiento físico y cognitivo de las personas mayores y frágiles. Los gestos afectivos evocados en la pintura y la sonificación interactiva son estímulos para la reactivación cognitiva y física.

DanzArte es un proyecto de Casa Paganini - InfoMus. Fundada en 1984, lleva a cabo investigación científica y tecnológica, desarrollo de sistemas multimedia y aplicaciones.

Uno de sus focos de investigación son la comprensión y desarrollo de modelos computacionales de expresión no verbal, cruzando teorías humanistas, científicas y artísticas.

X

Musicians learning Machine Learning, a friendly introduction to AI

¿Qué es una red neuronal? ¿Cómo se entrena? ¿Qué diferencia hay entre machine learning y deep learning? ¿Qué es y qué no es inteligencia artificial?

En la sesión “Musicians learning machine learning. A friendly introduction to AI” descubriremos los básicos de la IA a través de ejemplos musicales con la participación de la científica y desarrolladora Rebecca Fiebrink, el investigador e ingeniero especialista en voz Santiago Pascual, el investigador de la Universidad de Urbino, Stefano Ferretti y la científica de datos en NTT DATA Nohemy Pereira-Veiga. Al final de la sesión no seremos capaces de programar un robot, pero la IA tendrá menos misterios.

Con el apoyo del British Council España.

La IA y los géneros musicales del futuro

La tecnología ha definido sonidos, estructuras, géneros y estilos musicales a lo largo de los siglos y, en 2021, podemos decir con (bastante) seguridad que la IA va a definir la historia de la música de los años venideros, y que unirá audiencias que se identificarán con esta nueva música hecha con AI.

Los participantes serán: Libby Heaney, artista, física cuántica y programadora, Nabihah Iqbal (artista y etnomusicóloga) Jan St. Werner de Mouse on Mars, y Marius Miron, investigador en la intersección de la tecnología musical con la IA y la transparencia y la justicia (Music Technology Group -UPF)

Con el apoyo del British Council España.

Hackathon outcome presentations

Presentaciones de resultados de AI and Music S + T + ARTS Festival Hackathon

El AI and Music and Music S + T + ARTS Festival empieza el 23 de octubre con dos hackatones de 24 horas en la UPC Campus Nord. Un Live Coding Hack presentado por NTT DATA y desarrollado por UPC y Sokotech, y un Educational Hack persentado por Ableton y desarrollado por UPC y Hangar. Los equipos seleccionados competirán para ganar premios y los ganadores presentarán sus resultados en vivo en el AuditoriCCCB by NTT DATA el 28 de octubre.

¡Dejad paso a los nuevos instrumentos!

La IA ha venido para revelar la verdadera naturaleza de los instrumentos digitales y para definir la música del futuro. Los instrumentos eléctricos (y electrónicos) aparecieron para imitar a los instrumentos acústicos y encontraron su verdadera personalidad cuando dejaron de imitarlos (una guitarra, un órgano eléctrico, una caja de ritmos).

Así pues, demos paso a los nuevos instrumentos musicales de naturaleza digital junto a los participantes en esta sesión: Douglas Eck, investigador en Google Magenta; Rob Clouth, músico, artista visual y desarrollador de software musical; Agoria, dj productor y mente curiosa; y Koray Tahiroglu, artista e investigador en la Universidad de Aalto.

Con el apoyo del British Council España.

¿Pueden las máquinas interpretar las emociones humanas?

La música es física y es matemáticas, pero esta no es la razón por la que nos gusta. La música nos gusta porqué nos hace sentir cosas, por tanto, es crucial explorar la percepción humana para poder entrenar a las máquinas y construir instrumentos y herramientas musicales que nos permitan ser expresivos con la música.

Esta es una sesión para descubrir cómo se enseña a las máquinas a escuchar, ver y sentir como lo haríamos los humanos.

Contaremos con la participación del científico y director de la facultad de Inteligencia Artificial y toma de decisiones (AI+D) del MIT, Antonio Torralba; con Luc Steels, profesor e investigador en el Institut de Biologia Evolutiva (UPF-CSIC) Barcelona y pionero de la IA en Europa; con Ioannis Patras, profesor e investigador de visión por computador y percepción humana en la Queen Mary University of London, y Shelly Knotts, artista e improvisadora, con experiencia como académica en el campo de la IA en la composición e improvisación.

Con el apoyo del British Council España.